علی صالحی | Ali Salehi

Data Scientist | ML Engineer

یک شیرازی هستم که لیسانس کامپیوترش رو اهواز گرفته و فوق لیسانس هوش مصنوعی رو از مشهد. الانم ساکن مشهدم و توی یک شرکت استارتآپی کار میکنم. کلاً دوست دارم با دادهها سر و کله بزنم ببینم چیزی میشه از توشون درآورد یا نه. استخراج الگو و مفاهیم از دادههای به ظاهر بینظم همیشه برام جذابیت داشته. اینجا هم وبلاگ شخصی منه و میخوام تجربیات مرتبط یا غیر مرتبط با دنیای تکنولوژی رو باهاتون به اشتراک بذارم.

آخرین مطالب وبلاگ

مهاجرت شناختی بزرگ: چگونه هوش مصنوعی هدف، کار و معنا را در زندگی انسانها متحول میکند!

در دنیای امروز، ما به نوع جدیدی از مهاجرت وارد شدهایم؛ مهاجرتی که نه در جغرافیا، بلکه در حوزه شناختی و فکری صورت میگیرد. هوش مصنوعی (AI) با سرعتی بیسابقه در حال تغییر و تحول در منظر شناختی ما است. در دو سال اخیر، مدلهای زبانی بزرگ (LLMs) به سطحی از توانایی دست یافتهاند که میتوان آن را معادل با تحصیلات دکترا در بسیاری از زمینهها دانست. این تغییرات به قدری سریع و شگفتانگیز هستند که به نظر میرسد ما در حال تماشای وقوع یک تغییر بزرگ هستیم، اما هنوز نمیتوانیم به وضوح تصور کنیم که این تغییر چگونه و چه زمانی اتفاق خواهد افتاد.

قدرت هوش مصنوعی و چالشهای آینده

وظایفی که روزگاری تنها به عهده افراد تحصیلکرده بود، مانند نوشتن مقاله، تألیف موسیقی، تنظیم قراردادهای حقوقی و تشخیص بیماریها، اکنون به راحتی توسط ماشینها انجام میشود. به عنوان مثال، در مقالهای از مجله نیویورکر، یک استاد تاریخ علوم در دانشگاه پرینستون به شگفتی خود از این که چطور NotebookLM گوگل ارتباطی بین نظریات فلسفه روشنگری و یک تبلیغ تلویزیونی مدرن برقرار کرد، اشاره کرده است.

با پیشرفت هوش مصنوعی، انسانها باید به دنبال حوزههای جدیدی از معنا و ارزش باشند؛ حوزههایی که ماشینها هنوز در آنها ضعیف هستند و شامل خلاقیت، استدلال اخلاقی، ارتباطات عاطفی و بافتن معناهای نسلها میباشد. این “مهاجرت شناختی” آینده کار، آموزش و فرهنگ را تعریف خواهد کرد و کسانی که به این تغییرات توجه کنند و برای آن آماده شوند، میتوانند فصل جدیدی از تاریخ بشر را رقم بزنند.

جستجوی زمینهای جدید

مانند مهاجران اقلیمی که به دلیل تغییرات جوی مجبور به ترک محیطهای آشنا میشوند، مهاجران شناختی نیز نیاز دارند تا زمینهای جدیدی پیدا کنند که مشارکتهای آنها ارزش داشته باشد. اما این زمینهای جدید کجا و چگونه قابل شناسایی هستند؟

پدیدهای به نام «پارادوکس موراوک» میتواند نوری به این موضوع بتاباند. این پدیده که به نام دانشمند اتریشی هانس موراوک نامگذاری شده، بیانگر این است که کارهایی که انسانها انجام آنها را دشوار میدانند، برای کامپیوترها آسان است و برعکس. به همین دلیل، انسانها باید به سمت کارهایی حرکت کنند که به مهارتهای انسانی مانند خلاقیت، همدلی و قضاوت اخلاقی نیاز دارند.

آینده کار در دنیای هوش مصنوعی

با پیشرفت سریع هوش مصنوعی، زمینههای امن برای تلاشهای انسانی به سمت خلاقیت، استدلال اخلاقی و ارتباطات عاطفی حرکت خواهد کرد. کارهای انسانی در آینده نزدیک به طور فزایندهای به مهارتهایی نیاز خواهد داشت که مختص انسانهاست. مانند مهاجران اقلیمی که به دنبال زمینهای حاصلخیز جدید هستند، مهاجران شناختی باید به سمت این حوزههای انسانی حرکت کنند، حتی در حالی که زمینهای قدیمی کار و یادگیری زیر پاهایشان در حال تغییر است.

چالشهای پیشرو

در نهایت، مهاجرت شناختی به معنای از بین رفتن تمام مشاغل نیست. این تغییرات به تدریج و به صورت ناهماهنگ در بخشها و مناطق مختلف انجام خواهد شد. بسیاری از مشاغل که به حضور انسانی، شهود و ایجاد روابط نیاز دارند، در کوتاهمدت ممکن است کمتر تحت تأثیر قرار گیرند. اما در عین حال، تغییر در ارزشگذاری و هدفگذاری برای کارهای انسانی همچنان به تغییرات عمدهای منجر خواهد شد.

شاید برخی بر این باور باشند که هوش مصنوعی دنیایی از فراوانی را به وجود خواهد آورد که در آن کار اختیاری میشود و خلاقیت شکوفا میشود. اما ما نمیتوانیم از تغییرات عظیمی که این آینده به همراه دارد غافل شویم. مشاغل به سرعت تغییر خواهند کرد و بسیاری از افراد ممکن است در یافتن معنا و هدف خود در دنیایی که ماشینها تواناییهایشان را به عهده میگیرند، با چالشهایی مواجه شوند.

نتیجهگیری

دوران هوش مصنوعی تنها به ساخت ماشینهای هوشمند و مزایای آنها محدود نمیشود، بلکه همچنین به مهاجرت به سمت درک عمیقتر و پذیرش آنچه ما را انسانی میسازد، مربوط میشود. آیا برای این تغییر بزرگ آمادهایم؟ آیندهای که به سمت آن حرکت میکنیم، چه شکلی خواهد داشت و ما چگونه میتوانیم از این تغییرات بهرهبرداری کنیم؟

در این سفر در حال تغییر، آیا شما نیز به دنبال زمینههای جدیدی برای رشد و ایجاد معنا هستید؟ بیایید با هم به این سؤال بیندیشیم و به آیندهای روشنتر و معنادارتر گام بگذاریم.

کاهش ریسک در نوسازی سیستمهای اصلی: یک رویکرد جامع

کاهش ریسک در نوسازی سیستمهای اصلی: یک رویکرد جامع

نوسازی سیستمهای اصلی (Mainframe)، بهعنوان یکی از چالشهای مهم در دنیای فناوری اطلاعات، همواره مورد توجه متخصصان و مدیران قرار دارد. سیستمهای اصلی، که بهعنوان قلب تپندهی بسیاری از سازمانها عمل میکنند، به دلایل مختلفی مانند نیاز به بهروزرسانی فناوری، بهبود کارایی و کاهش هزینهها، نیاز به نوسازی دارند. اما این فرآیند میتواند با ریسکهای قابلتوجهی همراه باشد. در این مقاله، به بررسی استراتژیهایی میپردازیم که میتواند به کاهش این ریسکها کمک کند و نوسازی را به یک فرآیند موفق تبدیل کند.

مقدمه

با افزایش نیاز به تکنولوژیهای نوین و رقابت در بازار، سازمانها دیگر نمیتوانند به سیستمهای قدیمی و ناکارآمد متکی باشند. نوسازی سیستمهای اصلی نهتنها به بهبود عملکرد و کارایی کمک میکند، بلکه به سازمانها این امکان را میدهد که بهروزتر شوند و خود را با تغییرات بازار وفق دهند. اما نوسازی سیستمهای اصلی بهخودیخود میتواند با چالشهایی همراه باشد. از جمله این چالشها میتوان به از دست دادن دادهها، عدم تطابق در عملکرد و مشکلات ناشی از بازنویسی کدها اشاره کرد. بنابراین، درک عمیق از سیستمهای فعلی و برنامهریزی دقیق برای نوسازی آنها میتواند به کاهش این ریسکها کمک کند.

در این مقاله، به بررسی استراتژیهای مختلف برای کاهش ریسک در نوسازی سیستمهای اصلی خواهیم پرداخت. این استراتژیها شامل شناسایی نیازهای پنهان، برنامهریزی مرحلهای، تست و اعتبارسنجی دقیق، برنامهریزی برای بازگشت به حالت قبل و آموزش و انتقال دانش به تیمها است. با پیروی از این رویکردها، سازمانها میتوانند نوسازی موفقی را تجربه کنند که نهتنها به بهبود عملکرد سیستمها کمک میکند، بلکه اعتماد کاربران و ذینفعان را نیز جلب میکند.

شناسایی نیازهای پنهان از طریق مصاحبه با ذینفعان

یکی از اولین مراحل در نوسازی سیستمهای اصلی، شناسایی نیازهای پنهان است. این کار میتواند از طریق مصاحبه با توسعهدهندگان با تجربه، معماران سیستم و کاربران کلیدی کسبوکار انجام شود. بهعنوانمثال، پرسیدن از آنها دربارهی چگونگی عملکرد سیستم فعلی و مشکلاتی که در گذشته با آن مواجه شدهاند، میتواند دیدگاههای ارزشمندی را به همراه داشته باشد.

این مصاحبهها میتوانند داستانهای جنگی از تیمهای عملیاتی را به همراه داشته باشند که بهطور غیرمستقیم، نیازهای مهمی را شناسایی میکنند. بهعنوان مثال، ممکن است یکی از اعضای تیم عملیاتی داستانی از بروز مشکل به دلیل شناسههای منفی تراکنشها تعریف کند که نیاز به نصب یک افرونه در سال 1400 برای جلوگیری از این مشکل داشته است. اینگونه اطلاعات میتواند به شناسایی الزامات ضمنی کمک کند که باید به سیستم جدید منتقل شوند.

بازسازی مستندات

در صورتی که مستندات رسمی ناقص یا قدیمی باشد، بازسازی آنها یک ضرورت است. حتی یک ویکی ساده یا یک مخزن از یافتهها که شامل برنامهها، عملکرد آنها و ورودی/خروجیهای نمونه باشد، میتواند بهعنوان یک نجاتدهنده عمل کند. تشویق تیم به مستندسازی در حین یادگیری نیز بسیار مهم است. این مستندات نهتنها راهنمایی برای توسعه فراهم میکنند، بلکه بهعنوان یک مرجع در تست و نگهداریهای آینده نیز عمل میکنند.

ریسک نوسازی را کاهش دهید

هرچه اطلاعات بیشتری دربارهی سیستم قدیمی داشته باشید، شگفتیهای کمتری در آینده خواهید داشت. با انجام خوب اکتشاف، شانس از دست دادن یک قاعده کسبوکار یا وابستگی حیاتی هنگام انتقال به سیستم جدید بهطور چشمگیری کاهش مییابد. در واقع، شما در حال روشن کردن تمام زوایای تاریک سیستم قدیمی هستید تا هیچ مشکلی در زمان نوسازی پنهان نماند.

برنامهریزی مرحلهای و تدریجی برای نوسازی

پس از شناسایی نیازها و الزامات، مرحله بعدی برنامهریزی برای نوسازی بهصورت مرحلهای و تدریجی است. این استراتژی یکی از مهمترین روشهای کاهش ریسک در نوسازی سیستمهای اصلی است:

از تلاش برای انجام همهچیز بهصورت همزمان خودداری کنید.

تقسیم بر اساس عملکرد کسبوکار

یکی از روشهای تقسیم نوسازی، شناسایی بخشهای مستقل از عملکرد است که میتوان آنها را بهصورت جداگانه نوسازی کرد. بهعنوانمثال، در یک سیستم بانکی، ممکن است با مهاجرت قابلیت جستجوی مشتری و پرسوجوی حسابهای پایه به یک میکروسرویس جدید شروع کنید، درحالیکه پردازش تراکنشها هنوز بر روی سیستم اصلی باقی میماند. اینگونه میتوان با یک بخش در هر زمان کار کرد و همزمان یاد گرفت.

الگوی خفهکننده

الگوی خفهکننده (Strangler Pattern) بهطور تدریجی سیستم قدیمی را از طریق مسیریابی جریانهای خاص به خدمات جدید در طول زمان نابود میکند. این الگو بهگونهای عمل میکند که تماسهای جدید بهطور انتخابی به سیستم قدیمی یا مؤلفه جدید هدایت میشود. بهمرور زمان، نقش سیستم قدیمی کاهش مییابد تا جایی که میتوان آن را خاموش کرد.

اجرا و انتقال تدریجی

یکی دیگر از رویکردها این است که سیستم جدید را در کنار سیستم قدیمی بسازید و برای یک دوره بهصورت موازی اجرا کنید. در ابتدا، سیستم قدیمی بهعنوان سیستم اصلی ثبت باقی میماند، اما سیستم جدید با ورودیهای مشابه تغذیه میشود تا بار را شبیهسازی کند و اطمینان حاصل کند که نتایج مشابهی تولید میکند. هنگامی که اطمینان حاصل شد، بهتدریج کاربران و تراکنشهای واقعی به سیستم جدید منتقل میشوند.

با استفاده از یک روش مرحلهای، ریسک بهطور چشمگیری کاهش مییابد: حتی اگر یک بخش کوچک شکست بخورد یا به تأخیر بیفتد، تمام پروژه غرق نخواهد شد و میتوانید فقط آن بخش را به حالت قبل برگردانید. این رویکرد همچنین فرصتهای یادگیری زودهنگام و پیروزیهای اولیه را فراهم میکند.

فرآیندهای تست و اعتبارسنجی دقیق

تست بهعنوان شبکه ایمنی شما برای شناسایی مشکلات قبل از تأثیرگذاری بر کسبوکار عمل میکند. برای نوسازی، این تنها به تست ویژگیهای معمولی محدود نمیشود، بلکه معمولاً شامل تستهای مقایسهای بین سیستم قدیمی و جدید است.

اتوماسیون موارد تست

با استفاده از اطلاعات بهدستآمده در مرحله شناسایی، یک مجموعه تست جامع ایجاد کنید که شامل موارد استفاده شناختهشده و موارد حاشیهای از سیستم قدیمی باشد. بهعنوانمثال، اگر سیستم اصلی محاسبه خاصی برای نرخهای بهره با دقت هفت رقم اعشار دارد، این سناریو را در سیستم جدید تست کنید. هدف، اطمینان از این است که خروجی پیادهسازی جدید با خروجی سیستم قدیمی برای همان ورودی مطابقت دارد، مگر اینکه تفاوت بهصورت عمدی باشد.

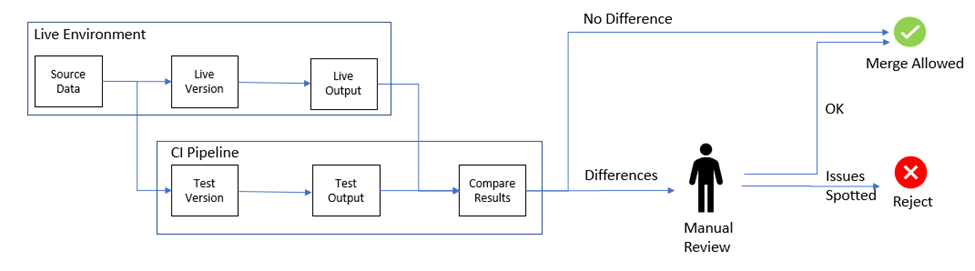

اجرای موازی و مقایسه

اگر امکانپذیر باشد، سیستم قدیمی و جدید را با ورودیهای یکسان بهصورت موازی اجرا کنید و نتایج را مقایسه کنید. هرگونه اختلاف یک علامت قرمز است که باید بررسی شود. این رویکرد میتواند تفاوتهای ظریفی را که ممکن است با ایجاد موارد تست دستی نادیده گرفته شوند، کشف کند.

تست بار و عملکرد

سیستمهای اصلی بهخاطر توانایی در مدیریت بارهای عظیم بهطور مؤثر شناخته شدهاند. پلتفرم مدرن شما باید ثابت کند که میتواند کارایی مشابه یا بهتری را ارائه دهد. تستهای استرس با حجمهای بالاتر از بار تولید اوج انجام دهید. نهتنها از نظر حجم، بلکه زمانهای پاسخ را نیز زیر نظر داشته باشید.

برنامهریزی برای بازگشت ایمن و برنامههای اضطراری

حتی با بهترین تستها، باید یک برنامه B داشته باشید. روز راهاندازی، چه اتفاقی میافتد اگر چیزی حیاتی خراب شود؟ برای این سناریو از پیش آماده شوید:

پنجرههای عملیاتی دوگانه

در نظر بگیرید که سیستمهای قدیمی و جدید را برای یک دوره اولیه بهصورت موازی اجرا کنید. به این ترتیب، اگر مشکلی کشف شود، میتوانید بهسرعت به سیستم قدیمی برگردید بدون اینکه نیاز به یک وقفه کامل باشد. این استراتژی به شما این امکان را میدهد که در صورت بروز مشکلات، از سیستم قدیمی بهعنوان پشتیبان استفاده کنید.

همگامسازی دادهها و پشتیبانگیری

یکی از چالشهای بازگشت به حالت قبل، انحراف دادهها است. اگر تراکنشهای جدیدی در سیستم جدید انجام شده باشد، چگونه میتوانید آنها را به سیستم قدیمی برگردانید؟ برنامهریزی برای این موضوع ضروری است.

سوئیچها

اگر ممکن است، سوئیچهایی برای روشن یا خاموش کردن برخی از قابلیتهای جدید پیادهسازی کنید. به این ترتیب، اگر یک جزء دچار مشکل شد، میتوانید آن را غیرفعال کنید درحالیکه بقیه سیستم جدید فعال است.

آموزش تیم و انتقال دانش

ریسک نوسازی تنها به کد محدود نمیشود، بلکه به افراد نیز مربوط میشود. برای کاهش ریسک از دست دادن دانش حیاتی، باید بهطور عمدی به مدیریت انتقال دانش و آموزش تیم بپردازید.

آموزش متقابل تیمها

توسعهدهندگان با تجربه را با کارشناسان فناوری مدرن در طول پروژه جفت کنید. این کار به هر دو طرف این امکان را میدهد که از یکدیگر یاد بگیرند و به کاهش وابستگی به یک فرد خاص کمک کند.

کارگاهها و دورههای آموزشی

اگر تیم شما دارای شکافهایی است، زمان مناسبی را برای برگزاری کارگاهها و دورههای آموزشی سرمایهگذاری کنید. حتی یک درک سطحی از “روش قدیمی” و “روش جدید” برای همه افراد درگیر، میتواند ارتباطات را تسهیل کند.

ایجاد دانش سیستم جدید زودهنگام

هنگامی که قطعات سیستم جدید ساخته میشوند، اطمینان حاصل کنید که تیم عملیات/پشتیبانی در حال یادگیری آنهاست. این کار به آنها اطمینان میدهد که در زمان راهاندازی، به خوبی آماده هستند.

حفظ تعادل بین قدیم و جدید در طول انتقال

در طول پروژه نوسازی، شما برای مدتی در یک حالت هیبریدی زندگی خواهید کرد — برخی از عملکردها بر روی سیستم قدیمی و برخی دیگر بر روی سیستمهای جدید. مدیریت این همزیستی بهطور دقیق اهمیت دارد.

حفظ ثبات سیستم قدیمی

ایدهآل این است که سیستم قدیمی در طول نوسازی تغییرات کمتری داشته باشد. بسیاری از تیمها یک “یخزدن کد” در سیستم قدیمی ایجاد میکنند، به جز برای اصلاحات حیاتی.

همگامسازی دادهها بین سیستمها

اگر هر دو سیستم قدیمی و جدید بهصورت موازی در حال اجرا هستند، اطمینان از انسجام دادهها ضروری است. بهعنوانمثال، اگر بهروزرسانیهای آدرس مشتری به سیستم جدید منتقل شوند، باید اطمینان حاصل شود که سیستم قدیمی نیز این تغییرات را دریافت میکند.

نظارت بر هر دو طرف

نظارت و گزارشگیری برای سیستم جدید و قدیمی در طول انتقال تنظیم کنید. بسیاری از مشکلات ممکن است در گزارشها بهعنوان عدم تطابقها ظاهر شوند.

نتیجهگیری

نوسازی سیستمهای اصلی هرگز کاملاً بدون ریسک نخواهد بود، اما با پیروی از استراتژیهای مناسب، میتوان ریسکها را به حد قابلمدیریتی کاهش داد. این به دانش، برنامهریزی و احتیاط بستگی دارد.

دانش: ناشناختهها را شناخته کنید. از مستندات و ابزارهای مناسب برای درک عمیق سیستمهای قدیمی استفاده کنید.

برنامهریزی: سفر را به مراحل امن تقسیم کنید. یک نقشه راه واضح، برنامه تست و گزینههای بازگشت داشته باشید.

ابزارها: ابزارهای مناسب را برای استفاده از هوش مصنوعی در نوسازی انتخاب و به کار ببرید تا آن را ایمنتر، سریعتر و ارزانتر کنید.

احتیاط در پیشرفت: نوسازی را در مراحل انجام دهید، اعتبار هر مرحله را بهطور دقیق تأیید کنید و در آنچه نباید عجله کنید، عجله نکنید.

با این رویکرد، نوسازی سیستمهای قدیمی به یک سفر موفق تبدیل خواهد شد و سازمانها میتوانند با اطمینان به آینده مدرن خود نگاه کنند.

آینده حریم خصوصی با هوش مصنوعی غیرمتمرکز

آینده حریم خصوصی با هوش مصنوعی غیرمتمرکز

دنیای امروز به شدت تحت تأثیر دادهها و اطلاعات قرار دارد. هر روزه ما بهعنوان کاربران اینترنت، حجم زیادی از اطلاعات شخصی و رفتارهای آنلاین خود را در اختیار شرکتهای بزرگ فناوری قرار میدهیم. این دادهها به طور معمول در سرورهای متمرکز ذخیره میشوند و به دست شرکتهای بزرگ افتاده و مورد تجزیه و تحلیل قرار میگیرند. اما آیا تا به حال فکر کردهاید که دادههای شما چه سرنوشتی پیدا میکنند و چقدر از حریم خصوصی شما در این پروسه نقض میشود؟ حالا وقت آن رسیده که به یک واقعیت تلخ توجه کنیم: دادههای ما نیاز به حفاظت بیشتری دارند و باید به ما برگردند. در این راستا، هوش مصنوعی غیرمتمرکز به عنوان یک راهحل نوآورانه و کارآمد در حال ظهور است که میتواند به ما در حفظ حریم خصوصی و امنیت دادههایمان کمک کند. در این مقاله، به بررسی مزایای هوش مصنوعی غیرمتمرکز و چگونگی بهبود حریم خصوصی و امنیت دادهها خواهیم پرداخت و به شما نشان خواهیم داد که چگونه میتوانید از این تکنولوژی برای حفاظت از دادههای خود استفاده کنید.

واقعیتهای تلخ درباره دادههای ما

در دنیای دیجیتال امروزی، دادهها به عنوان یکی از ارزشمندترین داراییها شناخته میشوند. زمانی که ما به اینترنت متصل میشویم، اطلاعاتی از قبیل مکان جغرافیایی، عادات خرید، و حتی جستجوهای شخصیمان را بهطور ناخواسته به اشتراک میگذاریم. شرکتهای بزرگ فناوری این دادهها را در سرورهای عظیم خود ذخیره کرده و در صورت لزوم به فروش میرسانند. این پروسه به ویژه در مواردی که دادهها به شرکتهای ثالث منتقل میشوند، خطرناک و نگرانکننده میشود.

بهطور خلاصه، شرکتها وعده میدهند که دادههای ما «ایمن» نگهداری میشوند، اما در عمل همواره شاهد نقض دادهها و افشای اطلاعات شخصی هستیم. این واقعیت تلخ، بهویژه زمانی که به نقضهای امنیتی بزرگ و افشای اطلاعات کاربران در سطح جهانی فکر میکنیم، به وضوح نمایان میشود. در این شرایط، هوش مصنوعی غیرمتمرکز به عنوان یک راهحل بالقوه برای بازگرداندن کنترل به کاربران و حفاظت از حریم خصوصی آنها معرفی میشود.

هوش مصنوعی غیرمتمرکز: دوست محترم فناوری

هوش مصنوعی غیرمتمرکز، به کاربران این امکان را میدهد که دادههای خود را در دستگاههای خود نگهداری کنند و به جای انتقال آنها به سرورهای متمرکز، از تکنولوژیهای توزیعشده برای پردازش اطلاعات استفاده کنند. این رویکرد نه تنها امنیت دادهها را افزایش میدهد بلکه به کاربران این امکان را میدهد که کنترل بیشتری بر روی اطلاعات شخصی خود داشته باشند.

تکنولوژیهای هوش مصنوعی غیرمتمرکز، مانند یادگیری فدراتیو و بلاکچین، به ما این امکان را میدهند که دادههای خود را خصوصی نگهداریم و در عین حال از قابلیتهای هوش مصنوعی بهرهمند شویم. با این روش، خطر افشای دادهها به حداقل میرسد و کاربران میتوانند تصمیم بگیرند که چه مقدار از اطلاعات خود را به اشتراک بگذارند. به عبارت دیگر، هوش مصنوعی غیرمتمرکز به کاربران این امکان را میدهد که بدون ترس از نقض حریم خصوصی، از تکنولوژیهای هوشمند استفاده کنند.

مزایای هوش مصنوعی غیرمتمرکز در حفاظت از دادهها

هوش مصنوعی غیرمتمرکز دارای مزایای متعددی است که آن را از هوش مصنوعی متمرکز متمایز میکند. در ادامه به برخی از این مزایا اشاره خواهیم کرد:

امنیت بالاتر

در سیستمهای متمرکز، دادهها در یک مکان واحد ذخیره میشوند که این موضوع خطر نقض امنیت را افزایش میدهد. اما در هوش مصنوعی غیرمتمرکز، دادهها در نقاط مختلف و به صورت توزیعشده ذخیره میشوند و این موضوع احتمال نفوذ به سیستم را به شدت کاهش میدهد.

حفظ حریم خصوصی

با هوش مصنوعی غیرمتمرکز، شما مالک دادههای خود هستید و هیچ کس نمیتواند بدون اجازه شما به آنها دسترسی داشته باشد. این موضوع به کاربران این اطمینان را میدهد که اطلاعات شخصی آنها تحت کنترل است و هیچکس به سادگی نمیتواند آنها را به فروش برساند.

شفافیت در استفاده از دادهها

هوش مصنوعی غیرمتمرکز به کاربران این امکان را میدهد که از نحوه استفاده از دادههای خود آگاه باشند. با استفاده از بلاکچین، هر تراکنش و استفاده از دادهها قابل ردیابی است و کاربران میتوانند از اینکه اطلاعاتشان به چه نحوی مورد استفاده قرار میگیرد، مطلع باشند.

کاهش وابستگی به واسطهها

در دنیای متمرکز، کاربران به واسطهها و شرکتهای بزرگ وابسته هستند تا خدمات خود را دریافت کنند. اما با استفاده از هوش مصنوعی غیرمتمرکز، این وابستگی کاهش مییابد و کاربران میتوانند بهطور مستقیم از خدمات بهرهمند شوند.

افزایش کارایی

هوش مصنوعی غیرمتمرکز میتواند به کاربران کمک کند تا با استفاده از دادههای محلی و توزیعشده، به نتایج هوشمندانهتری دست یابند. این روش باعث میشود که پردازش دادهها سریعتر و کارآمدتر انجام شود و نیاز به ارسال دادهها به سرورهای متمرکز کاهش یابد.

نتیجهگیری

در دنیای دیجیتال امروز، دادهها به عنوان یکی از ارزشمندترین داراییها شناخته میشوند و حفاظت از آنها از اهمیت بالایی برخوردار است. هوش مصنوعی غیرمتمرکز به عنوان یک راهحل نوآورانه، به ما این امکان را میدهد که کنترل بیشتری بر روی دادههای خود داشته باشیم و از حریم خصوصیمان حفاظت کنیم.

با توجه به مزایای هوش مصنوعی غیرمتمرکز، واضح است که این تکنولوژی میتواند به عنوان یک گزینه مناسب برای آینده دیجیتال ما در نظر گرفته شود. بیایید با هم این مسیر را طی کنیم و به یک آیندهای برسیم که در آن حریم خصوصی و امنیت دادهها بیش از پیش مورد توجه قرار گیرد.

در پایان، از شما دعوت میکنیم که به این موضوع بیشتر توجه کنید و در راستای حفاظت از دادههای خود و دیگران تلاش کنید. حریم خصوصی حق شماست و باید برای حفظ آن تلاش کنید.

آیا به هوش مصنوعی قابل اعتماد نیاز دارید؟ آن را بر روی بلاکچین قرار دهید

در سالهای اخیر، هوش مصنوعی (AI) به یکی از موضوعات داغ و پرطرفدار در دنیای فناوری تبدیل شده است. از چتباتها و دستیارهای مجازی گرفته تا الگوریتمهای پیچیدهای که در حوزههای پزشکی و مالی به کار میروند، هوش مصنوعی در زندگی روزمره ما حضوری پررنگ و غالب دارد. این فناوری به ما این امکان را میدهد که حجم وسیعی از دادهها را تحلیل کرده و تصمیمگیریهایی سریع و مؤثر انجام دهیم، اما در عین حال سوالات و چالشهایی را نیز به همراه دارد.

چالش اصلی این است که بسیاری از سیستمهای هوش مصنوعی به صورت یک “جعبه سیاه” عمل میکنند. این جعبه سیاه معمولاً ما را از فرآیند تصمیمگیری این سیستمها دور نگه میدارد. ما ممکن است پاسخهایی مانند “وام شما تأیید شد!” یا “متأسفم، دوباره تلاش کنید!” را دریافت کنیم، اما در این میان، اطلاعاتی از چگونگی رسیدن به این تصمیمات نداریم. این عدم شفافیت میتواند منجر به بیاعتمادی شود، به ویژه زمانی که این تصمیمات بر زندگی ما تأثیر مستقیم دارند.

علاوه بر این، تمرکز قدرت در دست چند شرکت بزرگ، نگرانیهای جدی را در مورد حریم خصوصی و کنترل دادهها به وجود میآورد. این مقاله به بررسی چالشهای موجود در حوزه هوش مصنوعی، اهمیت شفافیت و نقش بلاکچین و هوش مصنوعی غیرمتمرکز میپردازد.

چالشهای هوش مصنوعی و عدم شفافیت

یکی از بزرگترین چالشها در حوزه هوش مصنوعی، عدم شفافیت در نحوه کارکرد این سیستمها است. بسیاری از ما با این واقعیت آشنا هستیم که دادههای ما به این سیستمها تغذیه میشود، اما معمولاً از اینکه این دادهها چگونه جمعآوری و تحلیل میشوند، بیخبر هستیم. این عدم آگاهی میتواند به نگرانیهای جدی در مورد حریم خصوصی منجر شود. به عنوان مثال، آیا دادههای ما به نحوی مورد استفاده قرار میگیرند که به نفع ما باشد یا خیر؟

علاوه بر این، اگر تنها یک شرکت کنترل دسترسی به ابزارهای هوش مصنوعی را داشته باشد، این موضوع میتواند خلاقیت و نوآوری را محدود کند. در چنین شرایطی، اگر سیستم دچار نقص شود، کل فرآیند متوقف میشود و این یک نقطه آسیبپذیری جدی به شمار میآید. این نگرانیها باعث میشود که نیاز به شفافیت و اعتماد در سیستمهای هوش مصنوعی بیش از پیش احساس شود.

اهمیت شفافیت در هوش مصنوعی

برای اینکه بتوانیم به هوش مصنوعی اعتماد کنیم، نیاز به شفافیت در عملکرد این سیستمها داریم. این شامل پاسخ به سوالاتی مانند: از چه دادههایی برای آموزش این هوش مصنوعی استفاده شده است؟ این سیستم چگونه اطلاعات را پردازش کرده است؟ و چرا به این نتیجه خاص رسیده است؟

افزایش شفافیت در این زمینه به ما این امکان را میدهد که به صورت آگاهانهتری از ابزارهای هوش مصنوعی استفاده کنیم و بر روی فرآیندهای تصمیمگیری این سیستمها نظارت داشته باشیم. این نظارت میتواند به ما کمک کند تا از سوءاستفادههای احتمالی جلوگیری کنیم و اطمینان حاصل کنیم که دادههای ما به شیوهای اخلاقی و مسئولانه مورد استفاده قرار میگیرند.

بلاکچین و هوش مصنوعی غیرمتمرکز

برای ایجاد یک سیستم هوش مصنوعی قابل اعتماد، بلاکچین به عنوان یک راهحل جذاب مطرح میشود. بلاکچین به عنوان یک “ماشین اعتماد” شناخته میشود، زیرا اطلاعات در آن به صورت غیرقابل تغییر و شفاف ثبت میشوند. هر اقدام به صورت زمانبندی شده و با تأیید چندین کامپیوتر ثبت میشود، که این ویژگی باعث میشود دستکاری در دادهها غیرممکن باشد.

هوش مصنوعی غیرمتمرکز (DeAI) نیز به این معناست که دادهها و قدرت محاسباتی در شبکهای از چندین کامپیوتر پخش میشود، به جای اینکه در یک مرکز داده متمرکز قرار گیرد. این تغییر بنیادی نه تنها به بهبود حریم خصوصی و امنیت کمک میکند، بلکه دسترسی به منابع محاسباتی را برای شرکتهای کوچکتر و محققان نیز تسهیل میکند.

مزایای انتخاب پلتفرمهای غیرمتمرکز

انتخاب پلتفرمهای غیرمتمرکزبه معنای دسترسی به مزایای جدی است. این پلتفرمها به کاربران این امکان را میدهند که دادههای خود را با امنیت بیشتری مدیریت کنند و از ساختارهای غیرمتمرکز برای کاهش وابستگی به شرکتهای بزرگ فناوری استفاده کنند. همچنین این سیستمها به راحتی با دیگر شبکههای بلاکچین تعامل دارند و این امر به گسترش همکاریها و نوآوریها کمک میکند.

انتخاب پلتفرمهای غیرمتمرکز نه تنها به امنیت و حریم خصوصی دادهها کمک میکند بلکه به کاهش هزینهها و تسهیل دسترسی به منابع محاسباتی برای استارتاپها و تیمهای کوچک نیز میانجامد.

نتیجهگیری

با توجه به چالشهای موجود در حوزه هوش مصنوعی و نیاز به شفافیت و اعتماد، بلاکچین و هوش مصنوعی غیرمتمرکز به عنوان راهحلهای نوآورانه مطرح میشوند. این ترکیب نه تنها به ما این امکان را میدهد که از قدرت هوش مصنوعی به طور مؤثر استفاده کنیم بلکه به ما کمک میکند تا اطمینان حاصل کنیم که این سیستمها به صورت اخلاقی و شفاف عمل میکنند.

زمان آن رسیده است که به سمت آیندهای برویم که هوش مصنوعی نه تنها هوشمند باشد، بلکه قابل اعتماد و اخلاقی نیز باشد. بیایید به طور مسئولانه به ساخت آیندهای برای هوش مصنوعی بپردازیم که تمامی ما میتوانیم به آن اعتماد کنیم.

هوش مصنوعی: دستیار بسیار کارآمدی که نیاز به مدیریت دقیق دارد

مقدمه

در دنیای امروزی، هوش مصنوعی (AI) به عنوان یک ابزار کلیدی در بهبود عملکرد و افزایش بهرهوری در بسیاری از صنایع شناخته میشود. با پیشرفتهای سریع در این حوزه، بسیاری از شرکتها و سازمانها به دنبال راههایی هستند تا از این فناوری بهرهبرداری کنند. اما آیا واقعاً میتوان به هوش مصنوعی به عنوان یک دستیار بسیار کارآمد اعتماد کرد و او را بدون نظارت رها کرد؟ این سوالی است که در این مقاله به آن خواهیم پرداخت.

امروزه، هوش مصنوعی به عنوان یک نیروی کار جدید و ارزان قیمت در نظر گرفته میشود که میتواند حجم زیادی از کارها را به عهده بگیرد. اما این فناوری، نیاز به مدیریت و راهنمایی دقیق دارد تا بتواند به بهترین نحو عمل کند. در این مقاله، به بررسی این موضوع خواهیم پرداخت که چگونه میتوانیم از هوش مصنوعی به عنوان یک دستیار کارآمد بهرهبرداری کنیم و در عین حال، الزامات مدیریت آن را در نظر بگیریم.

۱. تعریف هوش مصنوعی و نقش آن در صنعت

هوش مصنوعی به مجموعهای از فناوریها و الگوریتمها اطلاق میشود که به سیستمها این امکان را میدهد که به صورت خودکار و بهینه به انجام کارها بپردازند. این فناوری میتواند در زمینههای مختلفی مانند پردازش زبان طبیعی، بینایی کامپیوتری، یادگیری ماشین و … به کار گرفته شود.

در صنعت، هوش مصنوعی به عنوان ابزاری برای افزایش بهرهوری و کاهش هزینههای تولید شناخته میشود. بهعنوان مثال، در بخش خدمات مشتری، هوش مصنوعی میتواند به طور خودکار به سوالات مشتریان پاسخ دهد و از بار کاری کارکنان بکاهد. این امر نه تنها به کاهش هزینهها کمک میکند، بلکه باعث افزایش رضایت مشتریان نیز میشود.

با این حال، استفاده از هوش مصنوعی نیازمند مدیریت دقیق و نظارت مستمر است. این فناوری، به تنهایی نمیتواند تمامی چالشها و مشکلات را حل کند و نیاز به کارشناسان انسانی دارد که بتوانند آن را هدایت و راهنمایی کنند.

۲. ضرورت مدیریت هوش مصنوعی

یکی از چالشهای اصلی در استفاده از هوش مصنوعی، نیاز به مدیریت آن است. به گفته جولی ژو، معاون سابق طراحی فیسبوک، هوش مصنوعی همانند یک نیروی کار جوان و کمتجربه است که برای دستیابی به بهترین نتایج نیاز به هدایت و نظارت دارد. این نظارت میتواند شامل بررسی خروجیهای تولید شده توسط هوش مصنوعی و اصلاح آنها باشد تا به نتایج مطلوب دست یابیم.

در واقع، هوش مصنوعی توانایی تولید ایدههای خلاقانه و نوآورانه را دارد، اما این ایدهها باید توسط کارشناسان انسانی بررسی و انتخاب شوند. به عبارت دیگر، در یک تیم کاری، هوش مصنوعی میتواند به عنوان یک ابزار مکمل عمل کند، اما لازم است تا انسانها به عنوان هدایتکنندهها و تصمیمگیرندهها در فرآیند حضور داشته باشند.

مدیریت هوش مصنوعی همچنین شامل آموزش و آشنایی تیمها با فناوریهای جدید است. کارکنان باید با نحوه استفاده از این ابزارها آشنا شوند و توانایی تجزیه و تحلیل دادههای تولید شده را داشته باشند.

۳. هوش مصنوعی در آینده کار

آینده کار به وضوح تحت تأثیر پیشرفتهای هوش مصنوعی قرار خواهد گرفت. به عنوان مثال، شرکتهایی مانند شاپیفای و دوولینگو اعلام کردهاند که به سمت “AI-first” حرکت میکنند، به این معنا که انتظار دارند کارکنان قبل از انجام کارهای دستی، از هوش مصنوعی بهرهبرداری کنند. این رویکرد، نشاندهنده تغییرات عمدهای در ساختار کار و فرآیندهای تولید است.

در این راستا، ایدهای که جولی ژو مطرح میکند، “باغ ایدهها” است. این مفهوم به تیمهای کوچک و چندنفره اشاره دارد که به پرورش ایدههای متنوع پرداخته و بر انتخاب بهترین آنها تمرکز میکنند. در این مدل، هوش مصنوعی نقش کلیدی ایفا میکند و میتواند به تولید ایدهها و پروتوتایپهای اولیه کمک کند.

استفاده از هوش مصنوعی در فرآیندهای کاری میتواند به طور قابل توجهی زمان و هزینهها را کاهش دهد و به تیمها این امکان را بدهد که بر روی پروژههای خلاقانه و استراتژیک تمرکز کنند.

۴. چالشها و موانع استفاده از هوش مصنوعی

اگرچه هوش مصنوعی فرصتهای بینظیری را برای کسب و کارها فراهم میکند، اما موانع و چالشهایی نیز وجود دارد که باید به آنها توجه کرد. یکی از این چالشها، نگرانیها در مورد حریم خصوصی و امنیت دادهها است. بسیاری از افراد نگرانند که استفاده از هوش مصنوعی ممکن است به نقض حریم خصوصی منجر شود و اطلاعات حساس آنها را در معرض خطر قرار دهد.

علاوه بر این، فقدان درک و آگاهی کافی از فناوریهای هوش مصنوعی در برخی از سازمانها میتواند به عدم پذیرش و استفاده مؤثر از این ابزارها منجر شود. آموزش و ارتقاء سطح آگاهی کارکنان در مورد امکانات و قابلیتهای هوش مصنوعی میتواند به کاهش این موانع کمک کند.

چالش دیگری که باید مورد توجه قرار گیرد، وابستگی بیش از حد به هوش مصنوعی است. در صورت اعتماد بیش از حد به این فناوری، ممکن است سازمانها از تخصص و تجربه انسانی خود غافل شوند و در تصمیمگیریها به مشکلات جدی برخورد کنند. بنابراین، ایجاد تعادل بین استفاده از هوش مصنوعی و توانمندیهای انسانی ضروری است.

۵. نتیجهگیری و دعوت به عمل

در نهایت، هوش مصنوعی به عنوان یک دستیار کارآمد و با پتانسیل بالا میتواند به بهبود عملکرد سازمانها کمک کند، اما لازم است تا به صورت هوشمندانه و با نظارت دقیق از آن بهرهبرداری شود. هوش مصنوعی به عنوان یک ابزار نیازمند هدایت انسانهاست و تنها در صورتی میتواند به نتایج مطلوب دست یابد که با همکاری و هماهنگی با تیمهای انسانی ترکیب شود.

به عنوان یک دعوت به عمل، از تمامی سازمانها و متخصصان دعوت میشود تا به بررسی و استفاده هوشمندانه از هوش مصنوعی بپردازند و از مزایای آن بهرهمند شوند. در این مسیر، توجه به آموزش و ارتقاء سطح آگاهی کارکنان و ایجاد تعادل بین فناوری و تخصص انسانی، کلید موفقیت در استفاده از این فناوری نوین خواهد بود.

هوش مصنوعی میتواند آیندهای روشن و پر از فرصتها را برای ما به ارمغان آورد، اما این آینده به انتخابها و تصمیمات ما بستگی دارد. بیایید با هم به ساختن آیندهای بهتر با هوش مصنوعی بپردازیم.

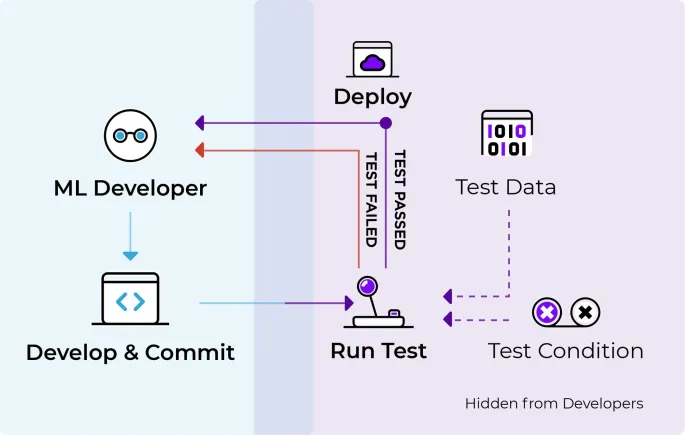

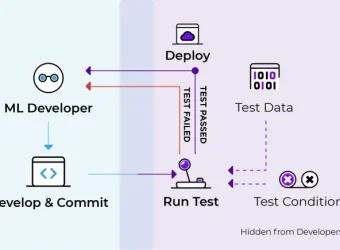

چطور مدلهای یادگیری ماشین رو تو محیط واقعی بدون دردسر تست کنیم؟ (پارت دوم)

انتخاب تکنیک آزمایش مناسب برای مدلهای یادگیری ماشین یکی از چالشهای مهمی است که هر استارتاپ یا تیم توسعهدهنده مدلهای یادگیری ماشین با آن مواجه میشود. در واقع، انتخاب تکنیک آزمایش مناسب برای مدلها به عوامل زیادی بستگی داره و نیاز به دقت و توجه به جزئیات داره. این که تکنیک آزمایش رو چطور انتخاب کنیم میتونه بر روی کارایی و عملکرد مدل در محیطهای واقعی تاثیر زیادی بذاره. توی این پست قصد دارم این موضوع رو بررسی کنم و نکات کلیدی که باید بهش توجه کنید رو توضیح بدم. اما قبلش لازمه که این پست رو خونده باشی!

۱. درک نوع و نیازهای مدل خود

اولین قدم برای انتخاب تکنیک آزمایش، اینه که شما باید نوع مدل یادگیری ماشین و نیازهای اون رو بهطور کامل درک کنید. مدلها انواع مختلفی دارن مثل مدلهای طبقهبندی، رگرسیون، توصیهگر و… هرکدوم از این مدلها به روشهای آزمایشی خاصی نیاز دارند. به عنوان مثال، مدلهای پیچیدهتری که دارای پارامترهای زیادی هستند، ممکنه به تکنیکهای آزمایشی دقیقتری مثل تست سایهای یا تست Interleaved نیاز داشته باشند.

اما مسئله فقط به پیچیدگی مدلها محدود نمیشه. شما باید تاثیر خطاهای احتمالی مدل رو هم بررسی کنید. برای مثال، در برنامههای با ریسک بالا مثل سیستمهای مالی یا بهداشتی، ممکنه لازم باشه که از تکنیکهای آزمایشی محتاطانهتر و دقیقتری استفاده کنید چون کوچکترین خطا میتونه به خسارات جدی منجر بشه.

۲. ارزیابی تکنیکهای آزمایش رایج

بعد از اینکه نوع مدل و پیچیدگی اون رو درک کردید، وقتشه که به سراغ تکنیکهای آزمایشی رایج برید. این تکنیکها، مثل چهار روشی که در بخشهای قبلی در موردش صحبت کردیم، هرکدوم مزایا و معایب خودشون رو دارن. مثلاً ممکنه تست سایهای رو بهعنوان یک روش کمریسک برای ارزیابی مدل جدید در نظر بگیرید، اما همزمان باید از محدودیتها و نیازمندیهای سختافزاری این روش هم آگاه باشید.

اینکه شما با چه نوع مدل و مشکلی مواجه هستید، تأثیر زیادی بر انتخاب تکنیک آزمایش میذاره. باید مطمئن بشید که تکنیک آزمایش مورد نظر میتونه بهطور مؤثر عملکرد مدل شما رو ارزیابی کنه و هیچ مشکلی برای کاربران یا مشتریها ایجاد نکنه.

۳. ارزیابی زیرساخت و منابع خود

در نهایت، یکی از عوامل مهم در انتخاب تکنیک آزمایش، منابع و زیرساختهای شماست. شما باید مطمئن بشید که محیط تولید شما قابلیت پشتیبانی از تکنیک آزمایشی انتخابی رو داره. بهطور مثال، آزمایش سایهای به زیرساختهای قوی و پردازش موازی نیاز داره. اگر منابع سختافزاری شما محدود باشه، ممکنه استفاده از این تکنیک مناسب نباشه.

همچنین باید منابع دیگهای مثل قدرت محاسباتی، ذخیرهسازی و ابزارهای نظارتی رو هم در نظر بگیرید. تکنیکهایی مثل آزمایش سایهای و آزمایش Interleaved معمولاً نیاز به منابع زیادی دارن. بنابراین، هنگام انتخاب تکنیک آزمایش برای مدلهای یادگیری ماشین، باید تمام این پارامترها رو بررسی کنید.

توجه به محدودیتهای اخلاقی و نظارتی در آزمایش مدلهای یادگیری ماشین

در دنیای امروز، حریم خصوصی دادهها و اخلاق دیجیتال برای کسبوکارها و کاربران یکی از مهمترین دغدغههاست. وقتی با دادههای حساس کار میکنید، رعایت مقرراتی مثل GDPR یا CCPA ضروریه. این موضوع بهویژه وقتی که به مدلهای یادگیری ماشین و دادههای حساس میپردازید اهمیت پیدا میکنه. برای مثال، وقتی مدل شما به پیشبینیهایی میپردازه که ممکنه به افراد یا گروههای خاص آسیب بزنه، باید مطمئن بشید که دادههای شما بهطور صحیح و اخلاقی استفاده میشن.

یکی از اصول مهم دیگه، انتخاب تکنیکهایی است که تبعیض مدل رو کاهش بده و عدالت رو در پیشبینیها تضمین کنه. یعنی مدل شما نباید بهطور غیرمنصفانه به یک گروه خاص از افراد امتیاز بده یا آسیب بزنه. اینجاست که دقت به اصول اخلاقی و نظارتی اهمیت پیدا میکنه.

نظارت و تکرار در آزمایش مدلهای یادگیری ماشین

آزمایش مدلهای یادگیری ماشین فقط یک مرحلهی اولیه نیست؛ بلکه یه فرآیند مداومه. عملکرد مدل شما و تغییرات دادهها باید بهطور مستمر پیگیری بشه تا از صحت پیشبینیها و نتایج اطمینان حاصل کنید. این یعنی شما باید مدل رو مرتباً بهروزرسانی کنید و با دادههای جدیدتر دوباره آموزش بدید.

برای این کار، میتونید یک حلقه بازخورد راه بندازید. این حلقه به شما کمک میکنه که با استفاده از دادههای عملکرد جمعآوریشده، مدل رو بهطور مرتب بهبود بدید و تطبیق بدید. این کار باعث میشه که مدل شما همزمان با تغییرات شرایط دنیای واقعی بهروز باشه و پیشبینیهاش دقیقتر بشه.

تکنیکهای آزمایشی برای مدلهای یادگیری ماشین

حالا که از اهمیت تکرار و نظارت گفتیم، باید به انتخاب تکنیکهای مناسب هم دقت کنیم. در بخش قبلی در مورد چهار روش اصلی آزمایش مدل یادگیری ماشین توضیح دادم. اینجا هم به طور تیتروار میذارمش که توی ذهنمون مرور بشه:

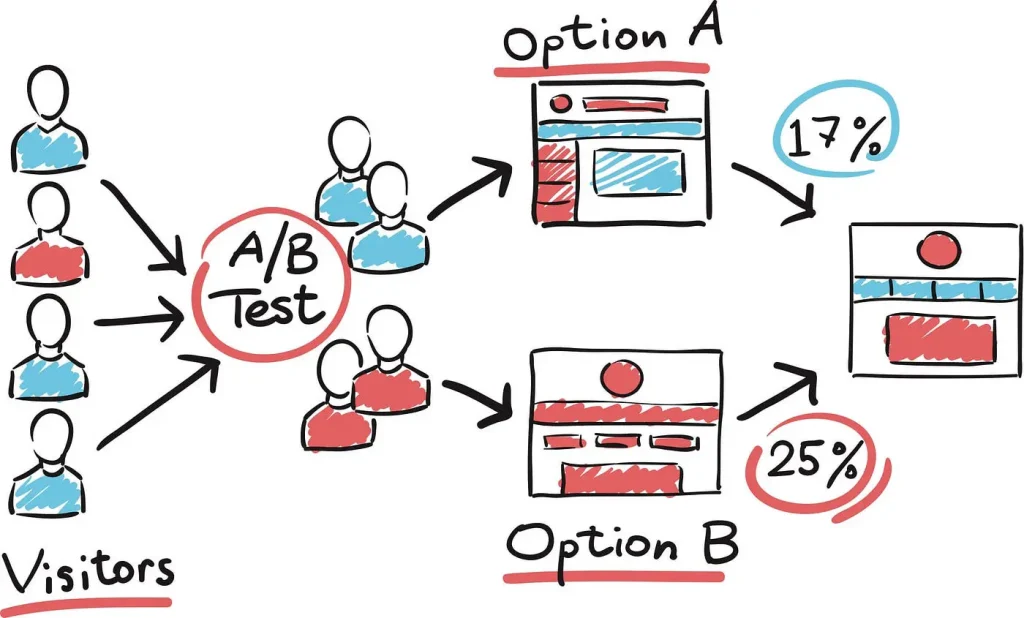

- A/B Test: برای مقایسه مستقیم عملکرد مدلها

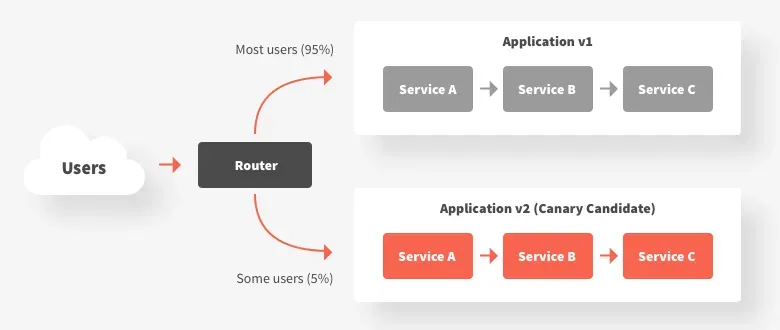

- Canary Test: برای استقرار تدریجی مدل جدید و اطمینان از عملکرد اون در شرایط واقعی

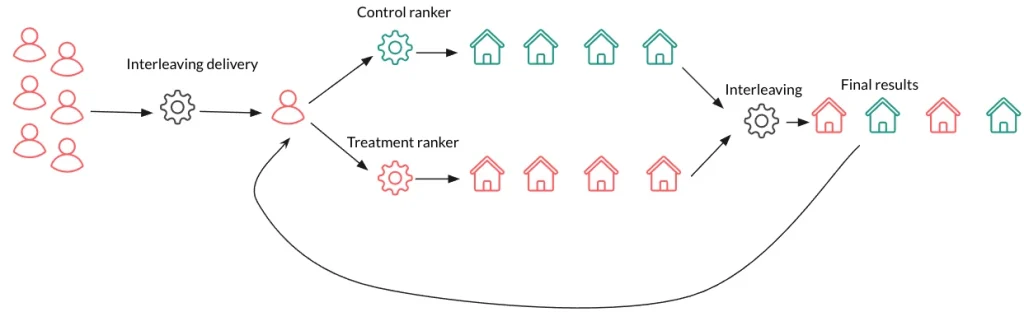

- Interleaved Test : برای ارزیابی همزمان خروجیهای مدلهای مختلف

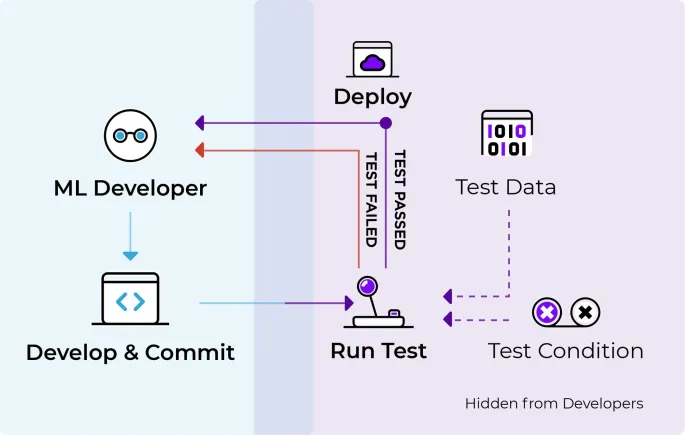

- آزمایش سایهای (Shadow Test): برای ارزیابی مدل جدید بدون ریسک تأثیرگذاری روی تجربه کاربری

جمعبندی

آزمایش مدلهای یادگیری ماشین در محیط تولید مرحلهای حیاتی برای اطمینان از قابلیت اعتماد، عملکرد و ایمنی مدلهاست. انتخاب تکنیک آزمایشی مناسب به شما کمک میکنه تا مطمئن بشید که مدلها به درستی عمل میکنند و آماده استقرار در شرایط واقعی هستند. علاوه بر این، میتونید با نظارت مداوم و استفاده از تکنیکهای مختلف آزمایشی، به بهبود عملکرد مدلهای خود ادامه بدید و استانداردهای ایمنی و قابلیت اعتماد رو رعایت کنید.

چطور مدلهای یادگیری ماشین رو تو محیط واقعی بدون دردسر تست کنیم؟

مدلهای یادگیری ماشین خیلی وقتها به چشم یک جعبه جادویی نگاه میشن که با دادهها کار میکنن و کلی نتایج شگفتانگیز بیرون میدن. اما این مدلها برای این که بتونن پیشبینیها و تصمیمگیریهای دقیق انجام بدن، باید حسابی آموزش ببینن و بعد از آموزش هم باید مطمئن بشیم که تو دنیای واقعی خوب کار میکنن. اینجا قراره درباره ۴ روش مختلف برای تست و اطمینان از عملکرد این مدلها تو شرایط واقعی صحبت کنیم.

مدلهای یادگیری ماشین دقیقاً چکار میکنن؟

مدلهای یادگیری ماشین مثل یه مغز مصنوعی عمل میکنن که با استفاده از دادههای قدیمی آموزش میبینن و تو دل دادهها دنبال الگوها و روابط مهم میگردن. بعد از آموزش، آماده هستن که وقتی با دادههای جدید مواجه میشن، پیشبینیهای دقیقی انجام بدن. امروزه کلی از شرکتها از این مدلها برای به دست آوردن یه برگ برنده تو بازار استفاده میکنن. از شخصیسازی تجربه مشتری گرفته تا پیشبینی خرابی تجهیزات و حتی تشخیص تقلب. خلاصه که این مدلها به شرکتها کمک میکنن که سریعتر، هوشمندتر و با دقت بیشتر تصمیم بگیرن.

تست مدلهای یادگیری ماشین چیه و چرا مهمه؟

وقتی میخوایم مدلهای یادگیری ماشین رو توی فرآیندهای روزمره و محیط واقعی پیادهسازی کنیم، نمیتونیم همینطوری بذاریم برن سر کار! لازمه که قبلش کلی تست و ارزیابی روی مدلها انجام بدیم که مطمئن بشیم تو شرایط واقعی خوب جواب میدن. تست مدل شامل یه سری مراحل مشخصه که سلامت دادهها رو بررسی میکنه، از عدم تعصب اطمینان حاصل میکنه و تعاملات بین اجزای مختلف مدل رو میسنجه.

هدف اصلی از تست مدل، پیدا کردن و رفع مشکلات احتمالی و آسیبپذیریهاست. این کار باعث میشه که مدل بتونه تو شرایط مختلف و حتی تو برخورد با ورودیهای غیرمنتظره هم عملکرد خوبی داشته باشه. همین طور، تعصبهای مدل کمتر میشه و نتایج مدل قابل اعتمادتر و عادلانهتر میشه.

تفاوت بین ارزیابی و تست مدل چیه؟

ممکنه براتون سؤال بشه که ارزیابی مدل با تست اون چه فرقی داره؟ خب، ارزیابی بیشتر به کارایی کلی مدل توجه داره و معیارهای مثل دقت، یادآوری، یا خطای میانگین رو بررسی میکنه. اما تست مدل بیشتر رو جزئیات و رفتار مدل تو سناریوهای واقعی تمرکز داره، مثل اینکه آیا باگها رو مدیریت میکنه، یا آیا تعصب داره یا نه.

در واقع، تست مدل یه جور ضمانته که این مدل توی شرایط واقعی خوب کار میکنه و میشه روش حساب کرد.

برای تست مدلهای یادگیری ماشین، مثل هر کار دیگهای که اهمیت زیادی داره، نیاز به ابزارهای درست و حسابی داریم. خوشبختانه چندین فریمورک عالی هستن که کارمون رو تو این زمینه خیلی راحتتر و سریعتر میکنن. این ابزارها به ما امکاناتی میدن که مدلهامون رو به شکلی ساختاریافته و کامل تست کنیم، مطمئن بشیم دادهها و مدلها درسته، و حتی بتونیم تستها رو دوباره تکرار کنیم تا نتایج دقیقتر و قابل اعتمادتر بشه.

در ادامه میخوام به چند تا از فریمورکهای کلیدی برای تست مدلهای یادگیری ماشین اشاره کنم که توی این زمینه حرف اول رو میزنن:

TensorFlow:

تنسرفلو سه ابزار اصلی برای تست مدلها داره:

- TensorFlow Extended (TFX): این فریمورک یه پکیج کامل برای مدیریت و تست خط لوله مدلهاست. TFX امکاناتی برای اعتبارسنجی دادهها، تحلیل مدل و حتی استقرار مدلها در محیطهای عملیاتی ارائه میده.

- TensorFlow Data Validation: این ابزار مخصوص تست کیفیت دادهها طراحی شده و مطمئن میشه که دادههایی که به مدل وارد میکنیم درسته.

- TensorFlow Model Analysis: این ابزار برای تحلیل عمیقتر مدل به کار میاد و به ما اجازه میده عملکرد مدل رو از زوایای مختلف بررسی کنیم.

PyTorch:

پایتورچ با گراف محاسباتی دینامیکش، خیلیها رو جذب خودش کرده. این فریمورک ابزارهای قدرتمندی برای ارزیابی مدل، اشکالزدایی و حتی بصریسازی فراهم کرده. مثلاً torchvision که شامل کلی مجموعهداده و تبدیل برای آزمایش مدلهای بینایی ماشین هست.

Scikit-learn:

سایکیتلرن از اون کتابخونههای چندمنظوره پایتونه که خیلی از افراد برای کارهای یادگیری ماشین ازش استفاده میکنن. این کتابخونه برای ارزیابی و تست مدلهای مختلف کلی معیار و ابزار داره، از جمله اعتبارسنجی متقابل و جستجوی شبکهای برای تنظیم هایپرپارامترها. خلاصه که سایکیتلرن برای تحلیل داده، استخراج دادهها و وظایف پایهی یادگیری ماشین عالیه.

Fairlearn:

یکی از مشکلات مهم مدلها، مسئله انصاف و تعصبه. فیرلرن یه ابزار تخصصیه که دقیقاً برای ارزیابی و کاهش تعصب و افزایش انصاف طراحی شده. این فریمورک الگوریتمهایی داره که با وزندهی دوباره به دادهها یا تنظیم پیشبینیها کمک میکنه تا مدلها عادلانهتر رفتار کنن و نتایج منصفانهتری ارائه بدن.

Evidently AI:

این ابزار منبع باز پایتون به تحلیل، نظارت و اشکالزدایی مدلها در محیط تولید کمک میکنه. Evidently AI خیلی به درد کسایی میخوره که میخوان مدلهاشون رو بعد از پیادهسازی زیر نظر داشته باشن و مطمئن بشن که همه چی داره درست کار میکنه.

این فریمورکها کمک میکنن مدلهای یادگیری ماشین در محیطهای عملیاتی هم پایدار و دقیق بمونن و نتایج قابل اعتمادی ارائه بدن. پس اگه مدل خوبی ساختین، این ابزارها رو فراموش نکنید تا مطمئن بشید که تو شرایط واقعی هم عالی عمل میکنه!

۴ روش برای تست مدلهای یادگیری ماشین در محیط تولید

وقتی به بحث تست مدلهای یادگیری ماشین میرسیم، نکات و روشهای مختلفی وجود داره که میتونه خیلی مفید باشه. در اینجا میخوام به چهار تا از اصلیترین روشها که برای تست مدلهای یادگیری ماشین توی محیط تولید استفاده میشه بپردازم. این روشها به ما کمک میکنن تا مطمئن بشیم مدلهای جدید نه تنها درست کار میکنن، بلکه به بهترین شکل ممکن دارن عمل میکنن.

A/B Test:

اولین روشی که میخوام در موردش صحبت کنم، آزمایش A/B هست. این روش برای مقایسه عملکرد دو نسخه از یک مدل به کار میره و کمک میکنه بفهمیم کدوم یکی از این مدلها توی شرایط واقعی بهتر عمل میکنه. نکته مهم اینه که قبل از اینکه مدل جدید رو بهطور کامل در محیط عملیاتی قرار بدیم، مطمئن بشیم که واقعاً ارزشش رو داره. اینطوری احتمال به وجود اومدن مشکلات غیرمنتظره خیلی کمتر میشه.

چطور کار میکنه؟ توی آزمایش A/B، درخواستهایی که به مدل ارسال میشن به دو بخش تقسیم میشن. یه بخش کوچک از ترافیک میره سمت مدل جدید تا بتونیم ریسکهای احتمالی رو مدیریت کنیم. بعد، عملکرد هر دو مدل رو با استفاده از یه سری معیارهای مشخص ارزیابی و مقایسه میکنیم.

مزایای آزمایش A/B:

- کاهش ریسک: چون فقط یه بخش کوچیک از ترافیک میره سمت مدل جدید، اگه مشکلی هم پیش بیاد، تأثیرش روی کل سیستم کمتره و میتونیم بهسرعت اصلاحش کنیم.

- اعتبارسنجی عملکرد: این روش به ما نشون میده که آیا مدل جدید بهاندازه مدل قبلی خوب عمل میکنه یا بهتره.

- تصمیمگیری دادهمحور: با نتایج آزمایش A/B، میتونیم بر اساس دادههای واقعی تصمیم بگیریم که آیا مدل جدید رو بهطور کامل جایگزین کنیم یا باید تغییرات بیشتری توش ایجاد کنیم.

بنابراین، آزمایش A/B یکی از مراحل کلیدی برای تست مدلهاست. این روش کمک میکنه مدل جدید رو توی شرایط واقعی بررسی کنیم و مطمئن بشیم که کارایی و اطمینان لازم رو داره، در حالی که ریسکهای مرتبط با مدلهای آزمایشنشده رو کاهش میده.

Canary Test:

آزمایش Canary یکی دیگه از روشهای خوب برای استقرار تدریجی مدلهای جدید در محیط تولید هست. این روش به ما اجازه میده که مدل جدید رو فقط برای یه گروه کوچیک از کاربران ارائه بدیم، تا اول عملکردش رو توی یه مقیاس کوچیک تست کنیم. به این گروه کوچیک از کاربران معمولاً میگیم “گروه Canary”.

هدف اصلی: ایده اصلی اینه که اول تأثیر مدل جدید رو محدود کنیم و هر مشکلی که ممکنه پیش بیاد رو با یه تعداد کاربر محدود تست کنیم. اگه همهچیز خوب پیش بره و مشکلی وجود نداشته باشه، به مرور مدل رو برای تعداد بیشتری از کاربران فعال میکنیم.

چطور کار میکنه؟ اول، مدل جدید رو فقط برای گروه Canary فعال میکنیم. اگه مدل توی این گروه عملکرد خوبی نشون داد، مرحله به مرحله تعداد بیشتری از کاربران بهش دسترسی پیدا میکنن. این کار تا جایی ادامه پیدا میکنه که همه کاربران از مدل جدید استفاده کنن.

مزایای آزمایش Canary:

- کاهش ریسک: این روش به ما کمک میکنه که مدل جدید رو کمکم تست کنیم و اگه مشکلی بود، قبل از اینکه همه کاربران متوجه بشن، اون رو رفع کنیم.

- محیط کنترلشده: این رویکرد به ما یه محیط امن برای نظارت و بررسی رفتار مدل جدید میده، تا بتونیم بر اساس دادههای واقعی هر تغییری که لازمه رو انجام بدیم.

- کاهش تأثیر بر کاربران: کاربران گروه Canary نشونههای اولیه مشکلات احتمالی هستن و این امکان رو به تیم میده که سریعاً اقدام کنن و از ایجاد تأثیر منفی برای بقیه کاربران جلوگیری کنن.

بهطور کلی، آزمایش Canary یه استراتژی موثر برای استقرار تدریجی مدلهای یادگیری ماشین هست که کمک میکنه مشکلات احتمالی سریعاً پیدا و رفع بشن، در حالی که کیفیت و پایداری سرویس هم حفظ میشه.

Interleaved Test:

آزمایش Interleaved یه روش جالب برای ارزیابی چند مدل یادگیری ماشینه که بهطور همزمان خروجیهاشون رو در یه رابط کاربری یا سرویس ادغام میکنه. این روش خیلی بدرد بخوره زمانی که بخوایم بدون اینکه فقط یه مدل رو در لحظه به کاربر نشون بدیم، عملکرد چند مدل رو کنار هم مقایسه کنیم.

چطور کار میکنه؟ کاربرها بدون اینکه متوجه بشن کدوم مدل کدوم قسمت از پاسخ رو تولید کرده، با یه خروجی ترکیبی از چند مدل تعامل میکنن. این باعث میشه که بشه بازخورد دقیقتری از تعامل کاربرها و معیارهای عملکرد برای هر مدل جمعآوری کرد و توی شرایط یکسان و واقعی مقایسه کرد که کدوم مدل بهتر عمل میکنه.

معیارهای عملکرد هر مدل با توجه به نحوه تعامل کاربرها دنبال میشه. مثلاً میشه معیارهایی مثل نرخ کلیک، میزان تعامل و نرخ تبدیل رو تحلیل کرد تا فهمید کدوم مدل برای استفاده توی محیط تولید مناسبتره.

مزایای آزمایش Interleaved:

- مقایسه مستقیم: آزمایش Interleaved یه مقایسه دقیق و همزمان از چند مدل رو تحت شرایط یکسان فراهم میکنه و به ما دید عمیقتری نسبت به عملکرد هر مدل میده.

- تجربه کاربری ثابت: چون کاربر بهطور همزمان با خروجیهای هر دو مدل مواجه میشه، تجربه کاربری کلی ثابت میمونه و ریسک نارضایتی کاربر کاهش پیدا میکنه.

- بازخورد دقیق: این روش به ما بازخورد دقیقی از چگونگی تعامل کاربران با خروجیهای هر مدل میده و کمک میکنه که عملکرد مدل رو بهینهتر کنیم.

بهطور کلی، آزمایش Interleaved یه روش خیلی کاربردیه که به دانشمندای داده و مهندسین کمک میکنه تا با مقایسه دقیقتر، تصمیم بگیرن کدوم مدل رو در تولید استفاده کنن و بتونن بهترین تجربه رو برای کاربرها ارائه بدن.

Shadow Test:

آزمایش سایهای یا همون “راهاندازی تاریک” یه تکنیک جذابه برای اینکه بتونیم یه مدل یادگیری ماشین جدید رو توی دنیای واقعی تست کنیم، بدون اینکه کاربرها متوجه بشن. این روش به ما امکان میده تا دادهها و بینشهای دقیقی از عملکرد مدل جدید بگیریم بدون هیچگونه ریسکی.

چطور کار میکنه؟ توی این روش، هر دو مدل جدید و قدیمی بهصورت همزمان اجرا میشن. برای هر درخواست ورودی، دادهها به هر دو مدل ارسال میشه؛ هر دو مدل پیشبینیهایی رو تولید میکنن، اما فقط خروجی مدل قدیمی به کاربر نشون داده میشه. پیشبینیهای مدل جدید بهصورت مخفی ثبت میشن و بعداً برای تجزیه و تحلیل عملکرد مدل جدید مورد بررسی قرار میگیرن.

این پیشبینیها با نتایج مدل قدیمی و دادههای واقعی مقایسه میشن تا عملکرد مدل جدید بهتر ارزیابی بشه.

مزایای آزمایش سایهای:

- ارزیابی بدون ریسک: چون نتایج مدل جدید به کاربر نشون داده نمیشه، اگر مشکلی هم وجود داشته باشه، هیچ تأثیری روی تجربه کاربری نداره. به همین خاطر، آزمایش سایهای یه روش امن برای بررسی مدلهای جدیده.

- دادههای واقعی: این آزمایش به ما این امکان رو میده که در شرایط واقعی عملکرد مدل رو بررسی کنیم، که خیلی دقیقتر از تستهای آفلاینه.

- معیارگذاری: این روش یه فرصت عالی برای مقایسه مستقیم مدل جدید با مدل قبلیه و کمک میکنه تا نقاط ضعف و قوت مدل جدید رو شناسایی کنیم.

آزمایش سایهای یه راه مطمئن برای آزمایش مدلهای جدید یادگیری ماشینه که به ما کمک میکنه بدون تأثیر روی کاربران، عملکرد مدل رو بهطور کامل ارزیابی کنیم و برای تصمیمگیری بهتر درباره استقرار مدلها اطلاعات ارزشمندی بهدست بیاریم.

توی پست بعدی در مورد اینکه چطوری یکی از این آزمایشها رو انتخاب و استفاده کنیم حرف میزنم.

آینده خدمات مشتری: یک سوم از مردم با عاملهای هوشمند راحتتر هستند!

در دنیای امروز، خیلی از مردم بدشون نمیاد که با یه عامل هوش مصنوعی صحبت کنن، البته به شرطی که بدونن دارن با یه ماشین حرف میزنن، نه یه آدم واقعی! تحقیقاتی که شرکت سیلزفورس (salesforce) انجام داده نشون میده که حتی یه سوم مردم ترجیح میدن برای خدمات سریعتر، با یه ربات هوشمند ارتباط داشته باشن. شاید براتون جالب باشه بدونید که تا سال ۲۰۲۸، پیشبینی شده حدود ۱۵٪ از تصمیمات کاری روزمره به طور خودکار توسط هوش مصنوعی گرفته بشه. پس بریم ببینیم که این فناوری چطور قراره دنیای کار و زندگی ما رو تغییر بده.

چرا اعتماد به هوش مصنوعی مهمه؟

تو دنیای پرسرعت امروزی، مشتریها دیگه فقط دنبال محصول خوب نیستن؛ تجربه خوب و راحت از برند رو هم میخوان. ولی این وسط یه مشکل بزرگ وجود داره: “اعتماد”. طبق گزارش سیلزفورس، ۷۲٪ از مردم نسبت به سال قبل، اعتمادشون به شرکتها کمتر شده. جالبه بدونید که ۶۰٪ از مصرفکنندهها فکر میکنن پیشرفت هوش مصنوعی، اعتماد به برندها رو حتی از قبل هم مهمتر کرده. اونا نگرانن که شرکتها در نگهداری و استفاده از دادههای خصوصیشون بیدقتی کنن.

یه نکته دیگه هم اینکه ۵۴٪ از کاربرهای هوش مصنوعی به دادههایی که برای آموزش این سیستمها استفاده میشه اعتماد ندارن. این یعنی مردم هنوز مطمئن نیستن که این فناوری، حریم خصوصیشون رو حفظ میکنه یا نه.

مردم چی میخوان؟

مشتریها دوست دارن هر وقت با یه شرکت در ارتباطن، تجربهای منظم و یکدست داشته باشن. ۶۹٪ از مصرفکنندهها انتظار دارن که تجربه تعامل با یه برند تو بخشهای مختلف شرکت، بدون هیچ ناهماهنگی باشه. همچنین، خیلی از افراد (حدود ۵۴٪) اصلاً براشون مهم نیست دارن با یه آدم یا یه هوش مصنوعی حرف میزنن، فقط میخوان مشکلاتشون سریع حل بشه! در ضمن، یه سوم از مردم ترجیح میدن خریدشون به صورت دیجیتالی یا خودکار باشه تا این که با یه فروشنده انسانی حرف بزنن.

شفافیت، رمز موفقیت در پذیرش هوش مصنوعی

برای این که مردم بیشتر از هوش مصنوعی استقبال کنن، لازمه که شرکتها شفافیت بیشتری داشته باشن. مثلاً ۷۳٪ از مردم میخوان بدونن دارن با یه ماشین حرف میزنن یا آدم واقعی. همچنین ۴۵٪ از مردم میگن اگه یه مسیر مشخص برای انتقال به نیروی انسانی وجود داشته باشه، راحتتر به استفاده از هوش مصنوعی اعتماد میکنن.

جمعبندی

هوش مصنوعی با سرعت داره وارد زندگی ما میشه و ممکنه حتی تو تعاملات روزمرهمون هم جای خودش رو پیدا کنه. اما مسئله اینجاست که هنوز برای خیلی از ما عادت به حرف زدن با یه ربات هوشمند راحت نیست. برای اینکه این فناوری واقعا بتونه موفق بشه، شرکتها باید بیشتر به شفافیت و جلب اعتماد مشتریها توجه کنن.

پنج اشتباهی که در ساخت هوش مصنوعی مولد نباید مرتکب بشیم!

توسعه و پیادهسازی هوش مصنوعی مولد (Generative AI) خیلی هیجانانگیزه، ولی پر از چالش و اشتباهاتیه که اگه ندونید، ممکنه باعث دردسر بشه. اینجا میخوام با شما پنج اشتباهی که ممکنه تو این مسیر باهاش مواجه بشید رو به اشتراک بذارم. اگه این نکات رو رعایت کنید، هم در هزینه و زمان صرفهجویی میشه و هم شانس موفقیت پروژه بالا میره.

به خروجی مدلهای زبانی بزرگ (LLM) اعتماد مطلق نکنید!

شاید فکر کنید مدلهای زبانی بزرگی مثل ChatGPT، Claude AI و Amazon Bedrock دیگه بینقص هستن و جوابهاشون قطعی و درسته. ولی واقعیت اینه که هنوز هم این مدلها اشتباه میکنن و حتی گاهی چیزهایی رو به هم میبافن که واقعی نیستن! مثلاً ممکنه در پاسخ به یه پرسش مالی پیچیده، اصطلاحاتی نامفهوم تولید کنن که تو دنیای واقعی معنی نداره. این نوع خطاها که به توهم مدل هم معروفه، باعث میشه خروجیها گاهی غیرقابل اعتماد بشه.

راه حل؟ اول از همه، دقیقتر و مشخصتر پرسشها رو مطرح کنید تا مدل به سمت جواب بهتری هدایت بشه. علاوه بر این، برای پروژههای حساس، بهتره که همیشه یه نفر به صورت دستی خروجیها رو بررسی کنه و از یه سیستم اعتمادسازی هم برای امتیازدهی به جوابها استفاده کنید. اینطوری، اگه مدل یه اشتباه هم کرد، متوجه میشید و کنترل بیشتری دارید.

خرج منابع پردازشی رو مدیریت کنید!

مدلهای زبانی و هوش مصنوعیهای مولد منابع پردازشی سنگینی میخوان و اگه دقت نکنید، میتونید با یه صورتحساب خیلی بالا روبهرو بشید. مثلاً پردازندههای قدرتمندی مثل TPUها هزینههای زیادی دارن و حتی یه پروژه کوچک هم اگه بهینهسازی نشده باشه، میتونه بار مالی زیادی ایجاد کنه.

چند تا راه ساده برای مدیریت هزینهها وجود داره. اول از همه، از ماشینهای مجازی موقت و ارزانتر استفاده کنید که اگه کارتون متوقف شد، راحت بشه دوباره از آخرین نقطه ادامه داد. اگه ماشینهایی دارید که زیاد بدون کار میمونن، حتماً زمانهای بیکاریشون رو شناسایی و اونها رو خاموش کنید. بهعلاوه، مدلهای متنباز میتونن هزینهها رو به شدت کاهش بدن و بهتون این امکان رو میدن که نوآوری بیشتری انجام بدید.

تجربه کاربری (UX) رو فراموش نکنید!

فرض کنید کلی وقت و انرژی گذاشتید و یه مدل هوش مصنوعی فوقالعاده ساختید، ولی وقتی کاربر باهاش کار میکنه، نمیتونه باهاش ارتباط برقرار کنه و زودتر از چیزی که فکر میکردید، ازش دست میکشه. تجربه کاربری واقعاً اهمیت داره! هر چقدر مدل شما پیشرفته باشه، اگه نتونه به درستی با کاربر تعامل داشته باشه، خیلی زود از دور خارج میشه.

برای اینکه تجربه کاربری خوبی ایجاد کنید، حتماً از ابزارهای تست UX و بازخوردهای کاربرها استفاده کنید. مثلاً میتونید کاربرهای اولیه یا بتا داشته باشید که سیستم رو تست کنن و بازخورد بدن. ایجاد یه سیستم بازبینی انسانی که بتونه خطاها و مشکلات احتمالی رو بررسی کنه هم خیلی کمککنندهست.

اهمیت دادههای آموزشی رو دست کم نگیرید!

کیفیت دادههای آموزشی روی نتیجه نهایی تاثیر مستقیم داره. اگه دادههای نامنظم، پر از خطا یا حتی بیش از حد داشته باشید، مدلتون دچار مشکل میشه و ممکنه خروجیهای بیدقت و نامعتبر ارائه بده. این خطا به خصوص وقتی حساستر میشه که دادههای زیادی داشته باشید و ممکنه مدلتون دچار بیشبرازش بشه.

حتماً دادهها رو قبل از آموزش مدل تمیز کنید و اگه دادهها زیادی غیرمرتبط بودن، حذفشون کنید. مهندسی ویژگیها برای شناسایی ویژگیهای مهم خیلی مهمه. اگر منابع انسانی محدودی دارید، ابزارهایی مثل AutoML هم کمک میکنن که تا حدی پاکسازی دادهها و آموزش مدلها رو اتوماتیک کنید.

استراتژی مقیاسگذاری درست انتخاب کنید!

وقتی پروژهتون به مرحله مقیاسگذاری میرسه، این سوال پیش میاد که چطور مدل رو گسترش بدید تا هم عملکردش بالا باشه و هم منابع بهینه مصرف بشه. مثلاً مدل رو میتونید بین چندین دستگاه تقسیم کنید یا دادهها رو توی دستگاههای مختلف توزیع کنید.

استفاده از موازیسازی مدل یا داده بستگی به نیاز شما داره، ولی چیزی که مهمه اینه که قبل از مقیاسگذاری، یه برنامه دقیق داشته باشید. بعضی وقتها افزایش منابع یه دستگاه مثل GPU بهتر جواب میده و در بعضی موارد هم موازیسازی بهترین گزینهست. برای مدیریت بهتر، میتونید از کانتینرها مثل Docker استفاده کنید تا مطمئن بشید که مدلتون روی همه محیطها بدون مشکل کار میکنه.

جمعبندی

هر کدوم از این چالشها رو اگه ندیده بگیرید، ممکنه مسیر ساخت یه سیستم هوش مصنوعی مولد به مشکل بخوره. ولی اگه دقت و برنامهریزی داشته باشید، این مسیر میتونه هیجانانگیزتر و با خطاهای کمتر پیش بره. هوش مصنوعی پیچیدهست، ولی نتیجهای که میتونید با برنامهریزی و اجرای دقیق بگیرید، مطمئناً ارزشش رو داره.

ارتباط با من

علی صالحی

Data Scientist – ML Engineerخوشحال میشم که با من در ارتباط باشید و نظراتتون رو به اشتراک بذارید.

آدرس ایمیل: salehiali.data@gmail.com

.svg )

.svg )

.svg )